Índice

La teoría del caos se ha acabado resumiendo, de forma popular, por una especie de adagio: «El aleteo de una mariposa en Brasil puede provocar un tornado en Texas».

Aunque la imagen es ciertamente poética, la frase proviene del título de un estudio académico presentado en 1972 por un meteorólogo y profesor del Instituto de Tecnología de Massachusetts, Edward Lorenz.

Lorenz fue muy consciente de lo real que era aquella frase cuando trató de diseñar un programa de ordenador para predecir el tiempo meteorológico con mayor precisión y descubrió que sencillamente eso era imposible.

Dinámicos y no lineales

En 1776, el matemático francés Pierre Simon de Laplace comenzó a publicar los diversos volúmenes del Traité de Mécanique Céleste, donde el autor afirmaba que, de conocerse con precisión la velocidad y la posición de todas las partículas del universo en un momento dado, se podría predecir su pasado y su futuro. A finales del siglo XIX, otro matemático francés, Henri Poincaré advirtió que esto no es tan fácil como parecía, afirmando que conocer esas condiciones iniciales implicaba un esfuerzo mayúsculo.

Es decir, que incluso aceptado que todo estuviera determinado por leyes, esclarecer cómo interactuaban todas con todos los elementos de un sistema excedía nuestra capacidad de cálculo. Estaba naciendo la llamada «teoría del caos».

La teoría del caos se aplica a sistemas que, como la meteorología, presentan dos propiedades: son dinámicos (el comportamiento del sistema en un momento dado influye en el comportamiento futuro) y son no lineales (obedecen a relaciones exponenciales y no aritméticas).

Responder a la pregunta del tiempo que hará dentro de una semana, pues, nos obliga a tratar con un sistema dinámico no lineal. Es decir, a no ser capaces de capturar toda la complejidad y, por extensión, determinar qué pasó o qué pasará.

Lorenz y su equipo se dieron cuenta de tamaña complejidad a la que se enfrentaban cuando, al introducir los datos en un programa para pronosticar el tiempo que corría en un Royal McBee LGP-30 (que ocupaba toda una oficina con tubos de vacío que bombeaban grandes cantidades de calor), este ofrecía pronósticos distintos, aunque introdujeran los mismos datos y ejecutaran el mismo código.

Tras pasarse semanas depurando el software y comprobando el hardware, advirtieron que se habían equivocado: los datos de entrada no eran exactamente los mismos. Uno de los técnicos se había equivocado en el tercer decimal: concretamente, había introducido 29,517 como presión barométrica en una de las esquinas de la cuadrícula, en vez de 29,5168.

La diferencia era mínima, imperceptible, pero era suficiente para trastocar todo el resultado. Esto no significa que el comportamiento del sistema fuera aleatorio, sino que era tan, tan, tan sensible a todas las variables que resultaba imposible saber lo que pasaría si no se controlaban todas las variables por completo.

El problema de partida es que no podemos controlar todas las variables porque no disponemos de todos los datos exactos (ni siquiera sabemos cómo se pueden medir, quizá porque nosotros mismos formamos parte del sistema que estamos tratando de medir).

A veces esos datos sencillamente no se pueden obtener porque no tenemos herramientas lo bastante poderosas: por ejemplo, un termómetro nunca es perfecto. Estas inexactitudes, pues, se deben al error humano. Pero a ello se puede sumar, además, que el sistema no puede medirse sin intervenir en el propio sistema, sin afectarlo como observadores (para ver un objeto, por ejemplo, primero debe rebotar un fotón en el propio objeto que este incida en nuestro ojo, lo que desencadena una cascada neuroquímica que nos permite «ver»; pero si no hay fotón que «influya» en el objeto, sencillamente no podemos verlo).

¿Qué tiempo hará mañana?

En el 340 a. C., ya Aristóteles describía patrones del tiempo en su obra Meteorología. Sin embargo, no fue a partir del siglo XIX cuando empezaron a realizarse avances importantes en ese sentido.

Hoy en día sabemos que solo podemos pronosticar el tiempo con un porcentaje de acierto que nunca será total, aunque resulte que acertamos con bastante frecuencia, tal y como explica Nate Silver en su libro La señal y el ruido:

Así, si el meteorólogo local nos dice que mañana habrá un 40 por ciento de posibilidades de lluvia, podemos interpretarlo como que en un 40 por ciento de las simulaciones se desarrolló una tormenta, mientras que en el 60 por ciento restante, utilizando parámetros iniciales ligeramente diferentes, no fue así.

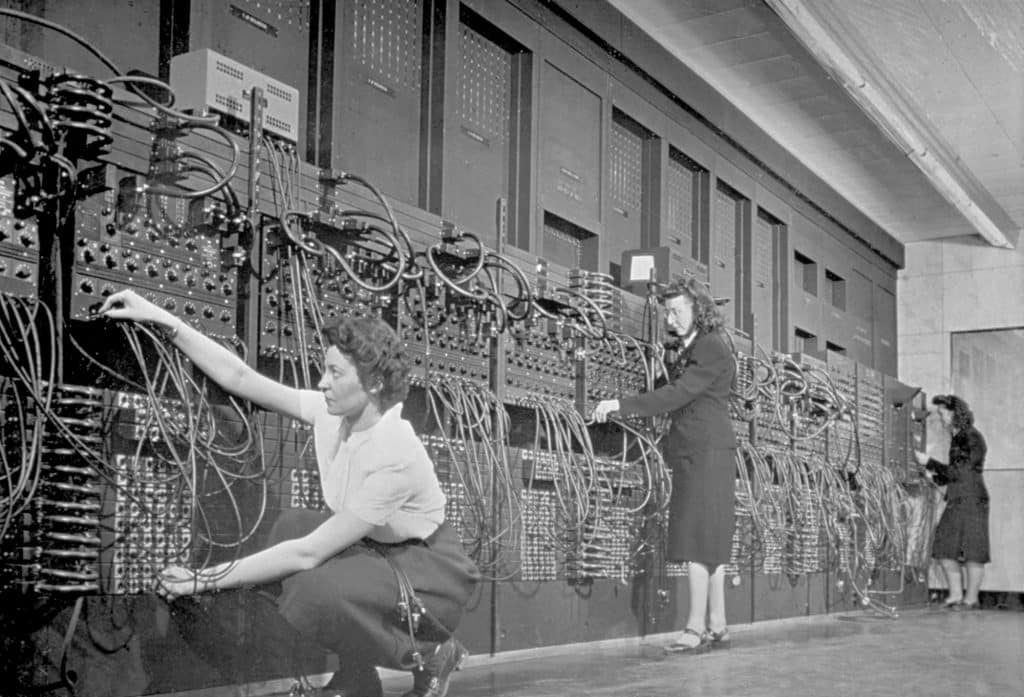

El primer logro en este nuevo campo de la meteorología se consiguió en 1950 por parte de un equipo compuesto por los meteorólogos estadounidenses Jule Charney, Philip Thompson, Larry Gates, el noruego Ragnar Fjörtoft y el matemático aplicado John von Neumann; empleando para ello la computadora ENIAC. Utilizaron una forma simplificada de la dinámica atmosférica basada en la ecuación de vorticidad barotrópica. La predicción meteorológica mediante modelos numéricos comenzó a funcionar, de manera regular, en 1955 bajo un proyecto conjunto de la Fuerza Aérea de los Estados Unidos y la Oficina Meteorológica.

Con todo, progresivamente se fue aceptando que había demasiadas variables que computar, y que la impredecibilidad era una característica intrínseca de la atmósfera.

Es decir, que estamos ante un nudo gordiano o serpiente de uróboros: para realizar una predicción del tiempo para dentro de dos meses (es una estimación), se necesitarían conocer las condiciones iniciales con una precisión unas 100.000 veces superior a la precisión obtenida por dicha predicción.

Dicho en román paladino: ¿mañana hará sol? Es probable, si así lo indica el parte meteorológico. Pero también puede no llover porque estemos cambiando el tiempo con nuestra propia medición. Y que, de resultas de ello, se desencadene un huracán en la otra punta del mundo.

Sergio Parra